XAI: Aufbau von Vertrauen und Transparenz bei Modellen für maschinelles Lernen

Da KI einen immer festeren Bestandteil in unserem Leben einnimmt, wird es zunehmend wichtiger, zu verstehen, wie diese Systeme funktionieren, und ihren Entscheidungen vertrauen zu können. Explainable AI (XAI) ist ein wachsendes Feld, das darauf abzielt, transparentere und interpretierbarere Machine-Learning-Modelle zu schaffen. In diesem Artikel werden wir untersuchen, was XAI ist, warum es wichtig ist und wie Techniken wie Entscheidungsbäume und regelbasierte Systeme verwendet werden können, um transparentere und vertrauenswürdigere KI-Systeme zu entwickeln.

Einführung

Künstliche Intelligenz (KI) wird zunehmend in einer Vielzahl von Anwendungen eingesetzt, von Chatbots bis hin zu autonomen Fahrzeugen. Da KI jedoch immer allgegenwärtiger wird, sind Bedenken hinsichtlich ihrer Transparenz und Verantwortlichkeit aufgetaucht. Insbesondere wächst die Nachfrage nach KI-Systemen, die erklärbar sind, das heißt, dass sie von Menschen verstanden und interpretiert werden können. Dieser Artikel wird das Konzept der erklärbaren KI untersuchen, einschließlich der Frage, warum sie wichtig ist, um Vertrauen in KI-Systeme aufzubauen, und wie Techniken wie Entscheidungsbäume und regelbasierte Systeme verwendet werden können, um transparentere und interpretierbarere Modelle zu schaffen.

Was ist Explainable AI?

Explainable AI (XAI) ist ein Teilbereich der KI, der sich auf die Entwicklung von Methoden und Techniken konzentriert, um KI-Systeme transparenter und interpretierbarer zu machen. Das Ziel von XAI ist es, Menschen zu ermöglichen, das Denken hinter KI-Entscheidungen und -Handlungen zu verstehen, was entscheidend für den Aufbau von Vertrauen in diese Systeme ist. XAI ist besonders wichtig in Bereichen mit hohen Einsätzen, wie zum Beispiel im Gesundheitswesen und im Finanzwesen, wo Entscheidungen, die von KI-Systemen getroffen werden, erhebliche Konsequenzen haben können.

Warum ist Explainable AI wichtig?

Der Mangel an Transparenz und Interpretierbarkeit in KI-Systemen ist ein großes Hindernis für deren breite Akzeptanz. Wenn Menschen nicht verstehen können, wie ein KI-System Entscheidungen trifft oder warum es eine bestimmte Aktion ausführt, werden sie dem System wahrscheinlich nicht vertrauen oder sich darauf verlassen. Dies gilt besonders in Anwendungen, bei denen Menschenleben oder Existenzen auf dem Spiel stehen.

Ein weiterer Grund, warum XAI wichtig ist, liegt darin, dass es helfen kann, Verzerrungen in KI-Systemen zu erkennen und zu mindern. Viele Machine-Learning-Modelle werden auf voreingenommenen Daten trainiert, was zu diskriminierenden Ergebnissen führen kann. Indem man KI-Systeme transparenter und interpretierbarer macht, wird es einfacher, Verzerrungen in diesen Modellen zu identifizieren und zu korrigieren.

Wie können wir Explainable AI erreichen?

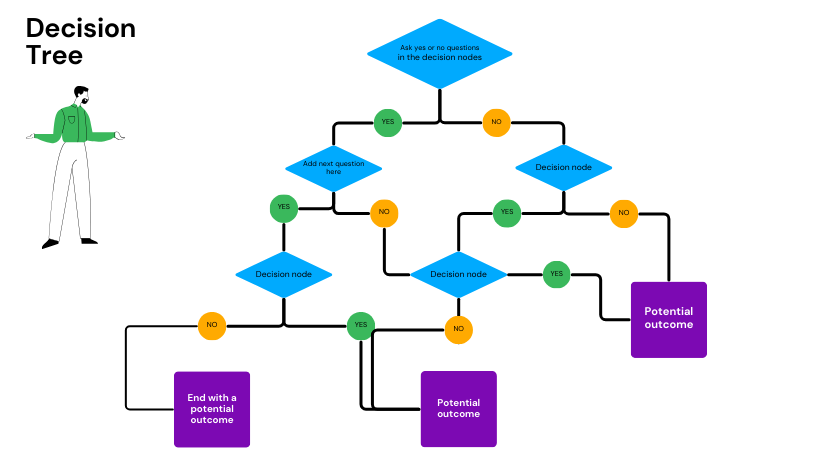

Es gibt verschiedene Techniken und Ansätze, um XAI zu erreichen. Ein häufiger Ansatz ist die Verwendung von Entscheidungsbäumen, bei denen es sich um eine Art von Modell handelt, das eine baumartige Struktur von Entscheidungen und deren möglichen Konsequenzen erstellt. Entscheidungsbäume sind leicht zu verstehen und können verwendet werden, um die Argumentation hinter KI-Entscheidungen nachzuvollziehen.

Beispiel eines Entscheidungsbaums

Ein weiterer Ansatz ist die Verwendung von regelbasierten Systemen, die aus einer Reihe von Regeln bestehen, die die Bedingungen definieren, unter denen bestimmte Aktionen ausgeführt werden sollen. Regelbasierte Systeme werden häufig in Expert:innensystemen eingesetzt, das sind KI-Systeme, die die Entscheidungsfähigkeiten eines menschlichen Expert:innen in einem bestimmten Bereich simulieren.

Ein dritter Ansatz ist die Verwendung von modellunabhängigen Techniken wie LIME (Local Interpretable Model-Agnostic Explanations) oder SHAP (Shapley Additive Explanations). Diese Techniken können mit jeder Art von Machine-Learning-Modell verwendet werden und bieten lokale Erklärungen für einzelne Vorhersagen.

Fazit

Explainable AI ist entscheidend für den Aufbau von Vertrauen und Transparenz in KI-Systemen. Indem wir KI-Systeme transparenter und interpretierbarer machen, können wir Verzerrungen identifizieren und korrigieren, Vertrauen bei den Nutzern aufbauen und sicherstellen, dass KI ethisch und verantwortungsbewusst eingesetzt wird. Es gibt viele Techniken und Ansätze zur Erreichung von XAI, und Organisationen sollten ihre Optionen sorgfältig abwägen, wenn sie KI-Systeme implementieren.

Prof. Dr. Florian Feltes

Prof. Dr. Florian Feltes ist Mitgründer und Co-CEO von zortify und Vorreiter der KI-gestützten HR-Innovation. Gemeinsam mit seinem Team entwickelt er intelligente Persönlichkeitsdiagnostik und hilft Unternehmen so, die perfekten Kandidat:innen zu identifizieren – ohne teure Assessments, ohne Bias. Seine Vision: Eine Welt, in der jedes Unternehmen mühelos High-Performance-Teams formt und Arbeitsumgebungen schafft, die menschliches Potenzial vollständig entfalten.

NLP 101: Ein Leitfaden für Einsteiger in die Verarbeitung natürlicher Sprache

KI vs. menschliche Intelligenz